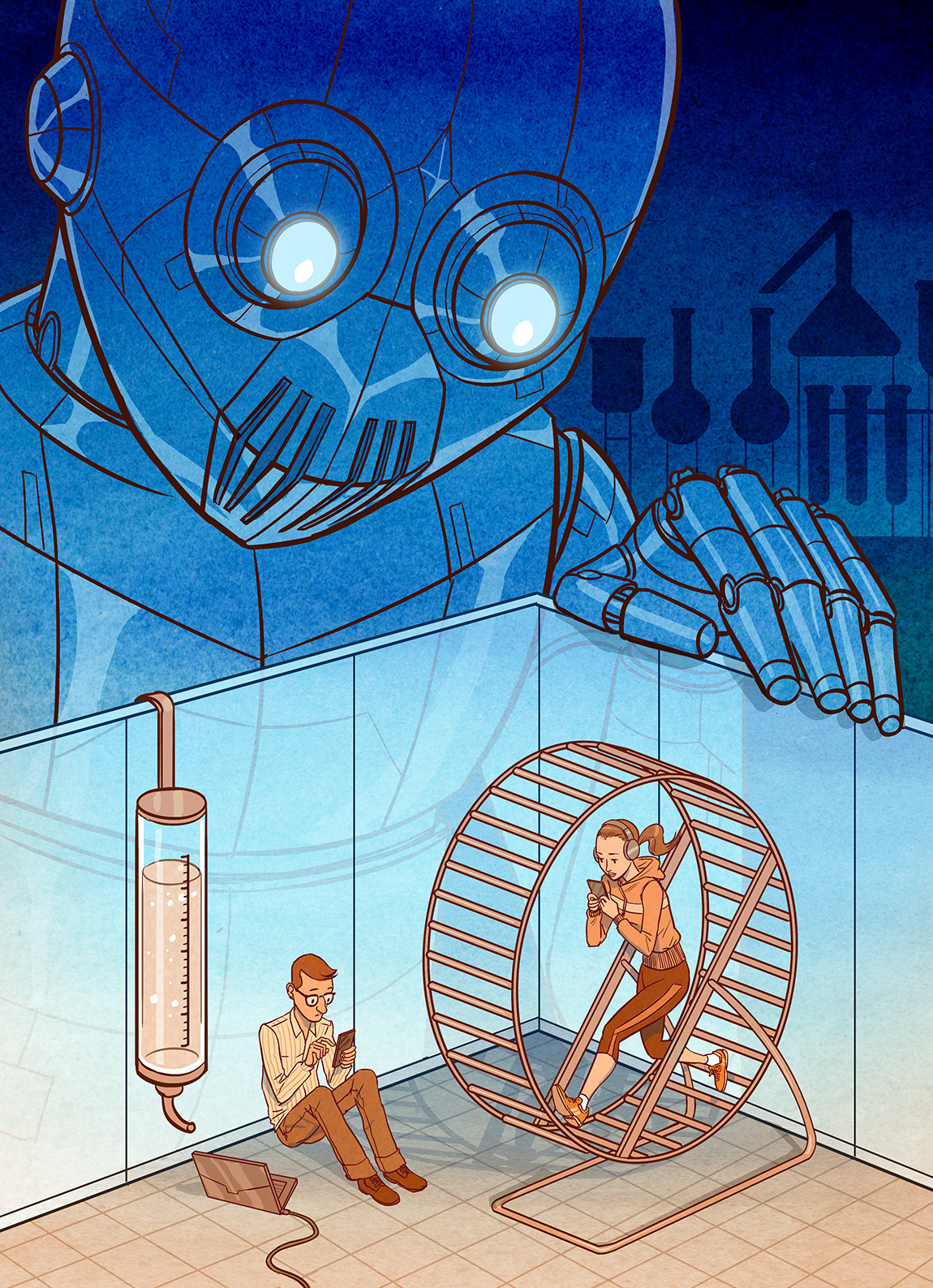

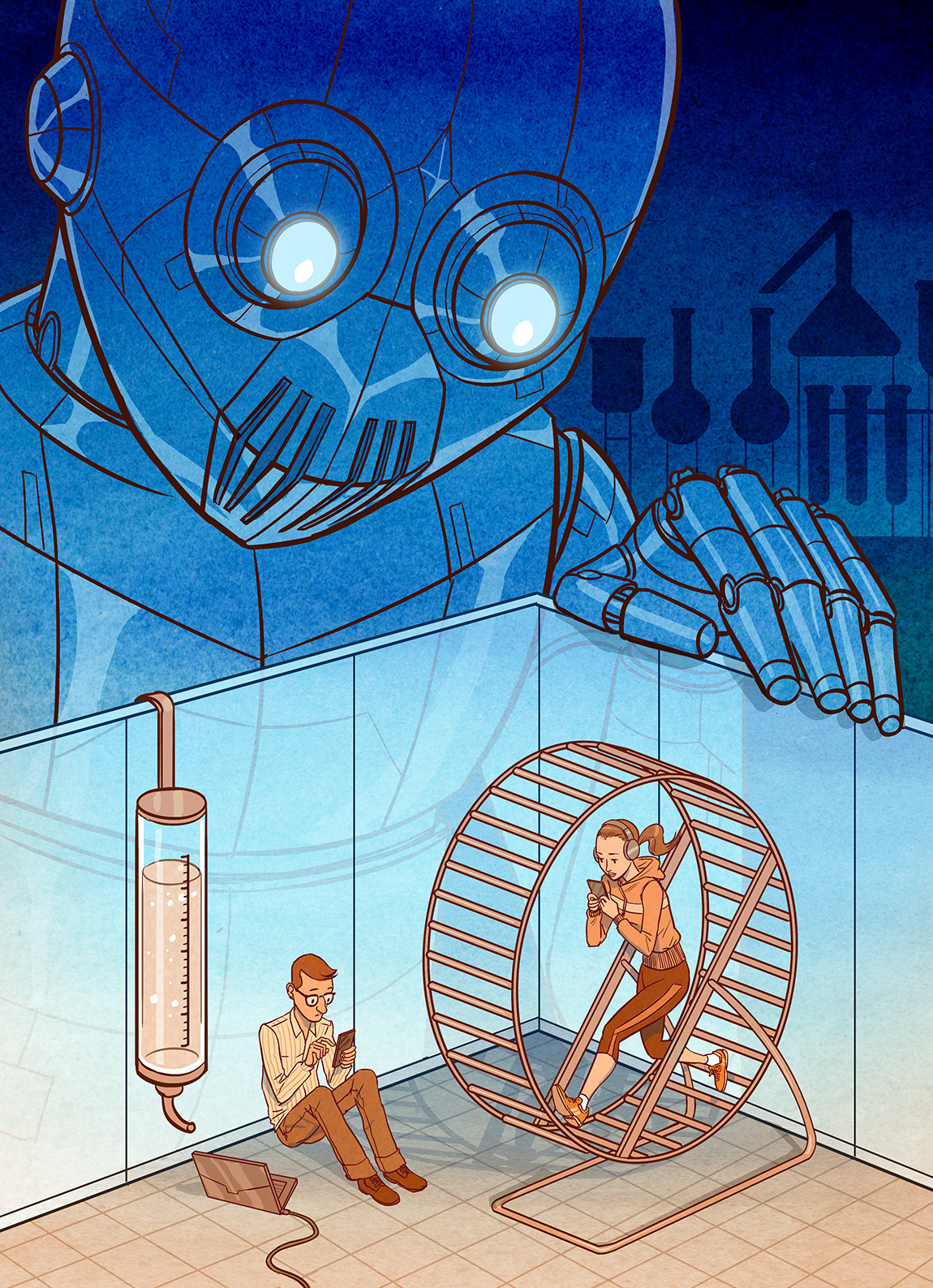

Какой вред можно причинить, доверив процесс искусственному интеллекту. Пример ЯндексДзен.

|

Искусственный

интеллект — это система, обязательно предусматривающая существование обратной

связи. Собственно говоря, громкое имя интеллекта программный комплекс получает

как раз за то, что его алгоритмы позволяют учитывать конкретную ситуацию и

адаптировать принимаемые решения к её специфике. Предполагается, что

искусственный интеллект способен учиться: с каждой новой ситуацией (циклом

обратной связи) его ответ становится всё более точным. Результат применения

такой технологии значительно превосходит как то, что может дать обычное

программное обеспечение, использующее типовые решения, так и то, что может

сделать человек. Пользователю не надо напрягаться, думать за него будет

компьютер.

Искусственный интеллект, конечно, может и ошибаться. Но люди также ошибаются, и

можно допустить, что средний человек сделает больше ошибок, чем «обученная»

система. Проблема доверия к искусственному интеллекту состоит не в возможности

ошибки как таковой, а в неприменимости к компьютерным системам понятия

ответственности.

Действия человека всегда связаны с последствиями для него лично. Если он

ошибётся, ему это каким-либо образом аукнется. Мы осознаём, что всякая ошибка

имеет свою цену, а если что-то прошло мимо сознания, подключается подсознание —

человеку просто не хочется что-то делать, как говорится, «душа не лежит». Или

наоборот: значимость последствий работает как стимулятор. Человек мобилизуется,

включает внимание, уделяет задаче больше времени, тратит больше сил и энергии.

Так или иначе, риск ошибки отражается на нашей деятельности, и в итоге

получается, что чем больше риск, тем менее вероятна ошибка.

У искусственного интеллекта нет шкуры, на которой он мог бы почувствовать

последствия своих решений. Компьютерная система — не субъект. Программисты

пытаются создать эмуляцию сознания, закладывая в систему аналоги потребностей,

чувств, интуиции и обучая компьютер уходить от жёсткой детерминированности. Но

всё это, в сущности, — не более чем имитация. Искусственный интеллект способен

симулировать личность, но никогда ею не будет, поскольку осознание себя не

является результатом вычисления. А это значит, что фактор риска компьютерная

система будет обрабатывать иначе, чем человек.

Не обладая сознанием опасности, программный комплекс способен учитывать лишь те

риски, которые уже распознаны и определены. Между тем, в реальной жизни каждая

новая ситуация может иметь новые, не встречавшиеся прежде последствия. Эта

область неизвестного в программных расчётах не учитывается, и потому любой

программный комплекс, каким бы надежным он ни казался, работая в области

определённого знания, по определению уязвим: достаточно возникновения

неожиданных обстоятельств (относящихся к новому, не встречавшемуся ранее

классу), и система ошибётся. Возникновение таких ошибок не зависит от степени угрозы:

система равновероятно пропустит и «копеечный» укол и разрушительный удар, если

они последуют из «слепой» зоны.

Когда ответственность лежит на человеке, это означает, что он стремится

обеспечить результат, не взирая на обстоятельства. Иными словами,

предполагается, что человек управляет результатом своих действий. Он может

ставить цели, добиваться их достижения или менять их, если цена их достижения

покажется ему слишком высокой. При этом само собой предполагается, что жизнь

может подкинуть любые сюрпризы.

Если мы перекладываем решение на компьютер, то надо понимать, что он не может

управлять результатом. И цели, и критерии действий ему задаёт человек. Поэтому

применение искусственного интеллекта, без сомнения повышающее эффективность

обработки тех прикладных задач, к решению которых он предназначен, обязательно

накапливает проблемы, скажем так, метауровня, которые искусственный интеллект

распознать просто не в состоянии. Ответственность в конечном счёте всё равно

лежит на человеке. Если человек будет считать, что искусственный интеллект

прекрасно справляется и никаких проблем его деятельность не порождает, то цена,

которую в итоге придётся заплатить за эту беспечность, будет тем больше, чем

дольше искусственный интеллект профункционирует в таком автономном

режиме.

В качестве примера работы искусственного интеллекта рассмотрим функционирование

платформы ЯндексДзен.

Общая идея ЯндексДзен состоит в том, чтобы предложить пользователю именно тот

контент, который ему наиболее интересен. Нейросеть анализирует наши поисковые

запросы и поведенческие характеристики (сколько мы находимся на той или иной

странице, дочитываем ли материал до конца и т.п.). На основании этих данных

подбираются публикации, которые составляют нашу персональную ленту. Понятно,

что свою долю постов в ленте Дзена получает реклама, но за их вычетом мы должны

увидеть зеркало наших собственных интересов.

Платформа предусматривает обратную связь. Пользователь может отмечать

понравившиеся ему посты (и подобного контента ему будет показываться больше),

подписываться на приглянувшихся авторов, блокировать нежелательную тематику,

удалять авторов из ленты. Можно попытаться приструнить даже рекламу.

Вроде бы мы имеем отличную реализацию применения искусственного интеллекта, и

можно смело использовать ЯндексДзен в качестве информационной кормушки: лента

принесёт то, что тебе захочется прочитать. Если в ней окажется что-то не то (то

есть программа подбора постов ошибётся), это всегда можно поправить -

искусственный интеллект воспримет ваш сигнал, обучится и скорректирует

выдачу.

Эта идеальная схема, в целом вполне успешно работающая на практике, тем не

менее чревата серьёзными побочными эффектами. Погружение в ЯндексДзен меняет

когнитивные (познавательные) привычки человека, что в конечном счёте отражается

на его личности.

Обратная связь оказывается двусторонней. Подобно тому как реакция пользователей

способствует обучению компьютерной системы, позволяя отсекать ошибочные и

закрепляя правильные решения, выдача, генерируемая искусственным интеллектом,

формирует ожидания пользователя и программирует его типовую реакцию. Если

ЯндексДзен становится основным каналом, поставляющим человеку новости и

информацию (а ведь это по-своему обоснованно: ведь человек сам настраивает свою

ленту, выбирая, что он хочет в ней видеть), то через какое-то время содержание

его сознания будет в значительной степени определяться тем, что ему дал

ЯндексДзен. И тут возникает вопрос: а что он вообще может дать?

По своей природе ЯндексДзен — не более чем агрегатор блогов, которые ведутся

здесь же, на Яндексе, по правилам, определяемым самим ресурсом. Какие-то блоги

— авторские, какие-то принадлежат юридическим лицам (СМИ или коммерческим

организациям), но, независимо от этого, цель у них одна — привлечь как можно

большую аудиторию. Яндекс поощряет это устремление, предусмотрев премиальные

показы и возможность монетизации для самых удачливых.

Имеет значение и то, как Яндекс оценивает успешность блога. Основными

показателями являются количество дочитываний и совокупное время, потраченное

читателями на прочтение материалов. Вполне осмысленные показатели, неправда ли?

А ещё Яндекс штрафует за неоригинальный контент (перепечатки из других

источников), ограничивая показы. Пиши сам, пиши интересно, тебя будут читать, и

чем больше прочтут, тем больше аудитория у тебя будет. Схема выглядит

справедливой, а стало быть, её реализацию можно только приветствовать.

Но есть подводный камень, о который всё разбивается. Конечным критерием,

лежащим в основании всей механики ЯндексДзен, является поведение пользователей.

А наше поведение вовсе не безупречно.

Человек не очень-то любит интеллектуально трудиться. Мы, конечно, читаем при

необходимости и серьёзные материалы, но с гораздо большим удовольствием мы

будем перелистывать красивые картинки, смотреть забавные сюжеты, читать

что-нибудь короткое, лёгкое и занимательное. Такой контент мы будем раскрывать

гораздо чаще. С другими поведенческими показателями тут тоже будет всё в

порядке: короткий текст проще дочитать до конца, и в совокупности на этот

информационный «песок» — маленькие и пустые сообщения — у нас уйдёт больше

времени, чем на считанные обращения к длинным и серьёзным текстам.

Распознав наши предпочтения, искусственный интеллект скорректирует персональную

выдачу, наполнив нашу ленту её ещё большим количеством подобных материалов.

Развлекать себя станет проще, а вероятность обнаружить что-нибудь действительно

стоящее будет стремиться к нулю. Некоторое раздражение по этому поводу, неизбежно

присутствующее поначалу, со временем уйдёт — человек хорошо адаптируется и

привыкает к любой информационной среде.

Аналогичный механизм действует и в отношении авторов публикаций. Поскольку

незатейливые и короткие материалы легко находят аудиторию, именно они собирают

показатели, необходимые для стабильного существования блога внутри ЯндексДзен.

Что бы там ни думал автор, если он хочет сделать свой блог популярным, его

материалы должны быть скорее развлекательными, чем серьёзными.

На выходе мы получаем систему, в которую заложена тенденция понижения

интеллектуального уровня публичной среды или, попросту говоря, работающую на

оглупление общества. При этом, заметим, никаких специальных установок на этот

счёт не предусмотрено. Нет никакой злой воли. Просто процесс полностью отдан

под контроль искусственному интеллекту. Этого оказалось достаточно.

Развитие возможно лишь там, где с людьми взаимодействуют люди. Поскольку человек

учитывает больше факторов, чем может быть заложено в алгоритм, имеет свои

предпочтения, на основании которых корректирует обратную связь, умеет

переступать через правила и нарушать предписания, взаимодействие с ним

оказывается по определению более насыщенным. И проблемным, конечно. Визави-человек

менее комфортен, чем-визави компьютер. Но эта некомфортность – тоже фактор

развития. Мы пытаемся объясниться, обосновать свою точку зрения, стараемся,

чтобы нас поняли, сами тратим силы на понимание, то есть предпринимаем кучу

самостоятельных действий, и в результате принимаем на себя ответственность за

результат.

По большому

счёту, нам ещё предстоит научиться работать с искусственным интеллектом. Игнорировать

его возможности – глупо. Нужно просто поставить его на надлежащее место. И не

позволять себе думать, что искусственный интеллект способен полностью закрыть

какой-нибудь вопрос и избавить нас от проблем. |

Культуролог в ЖЖ

Культуролог в ЖЖ  Культуролог в ВК

Культуролог в ВК